1-Einführung in die mathematische Statistik

Data Science 2

Saskia Otto & Monika Eberhard

Universität Hamburg, IMF & IZS

Sommersemester 2025

Modulübersicht

DS2 - Einführung in die Statistik und das experimentelle Design

Lernziele des Moduls

![]()

Am Ende des Semesters werden Sie …

- grundlegende Kenntnisse in den Bereichen der Wahrscheinlichkeitstheorie und Statistik haben,

- einen Überblick über verschiedene Datenverteilungen haben und in der Lage sein, auf Normalverteilung hin zu testen,

- die Konzepte der Datenerhebungen und den Zusammenhang zwischen experimentellem Design und statistischer Analyse besser verstehen,

- Hypothesen formulieren und statistische Testergebnisse hinsichtlich der Hypothesen interpretieren können und

- ein geschärftes Urteilsvermögen über geeignete und ungeeignete Methoden entwickelt haben.

Modulstruktur: Theorie & Praxis

Vorlesung

- Wöchentliche VL (45min)

- keine Anwesenheitspflicht

- VL-Aufzeichungen auf Moodle

Abschließende Klausur (Note)

- 90min, SC-, MC-, numerische Fragen

- 1. Termin am 11.7.2025, 10 Uhr (IPM)

- 2. Termin am 22.9.2025, 10 Uhr (IPM)

- ansonsten in jedem folgenden Sommersemester

Übungen

- 6 Übungstage (90min) ~ alle 2 W.

- Anwesenheitspflicht!

- Fehlzeiten max. 15% (1 Übungstag)

- Moodle-Quizze verpflichtend

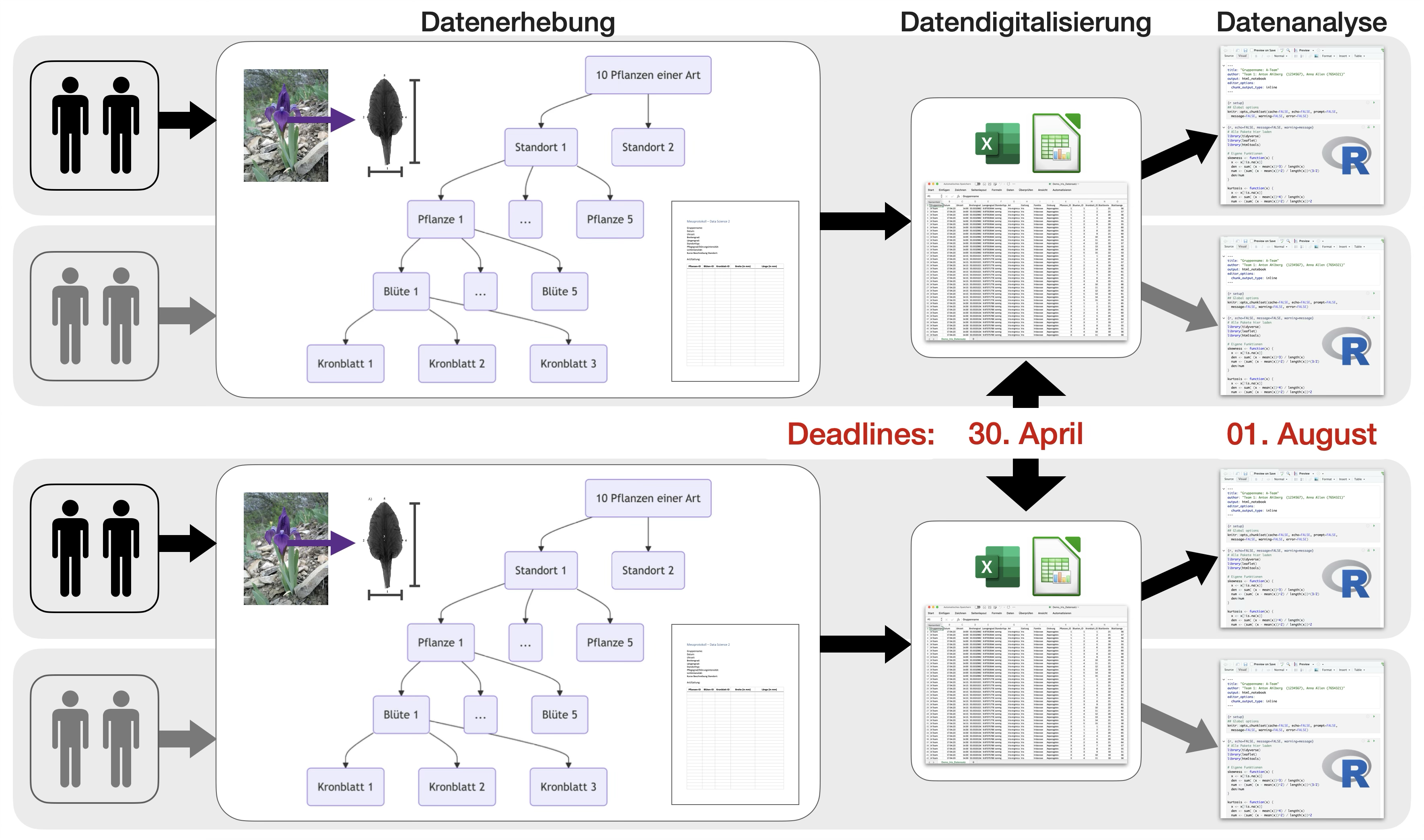

Fallstudie

- Datenerhebung: 30. April 2025

- Stat. Analyse: 1. August 2025

Das Modul wird als vollständig abgeschlossen betrachtet, sobald beide Komponenten erfolgreich absolviert wurden.

Vorlesungsthemen

| VL | Datum | Thema |

|---|---|---|

| 1 | 10.04.2025 | Einführung in das exp. Design & die mathematische Statistik |

| 2 | 17.04.2025 | Wahrscheinlichkeitstheorie |

| 3 | 24.04.2025 | Wahrscheinlichkeitsverteilungen |

| 4 | 01.05.2025 | VIDEO: Schätzverfahren |

| 5 | 08.05.2025 | Hypothesentests |

| 6 | 15.05.2025 | Klassische Tests zum Prüfen auf Unterschiede: metrische/ordinale Daten |

| 7 | 22.05.2025 | Klassische Tests zum Prüfen auf Unterschiede: nominale Daten |

| 8 | 05.06.2025 | Einfache Varianzanalyse (ANOVA) |

| 9 | 12.06.2025 | Korrelation, Transformation |

| 10 | 19.06.2025 | Einfache lineare Regression |

| 11 | 26.06.2025 | Grundlagen des exp. Designs I - Kriterien & Poweranalyse |

| 12 | 03.07.2025 | Grundlagen des exp. Designs II - Designtypen |

| 13 | 10.07.2025 | Fallstudienbesprechung/Fragenrunde |

Eine Übersicht der Übungsgruppen-Termine wird auf Moodle angezeigt.

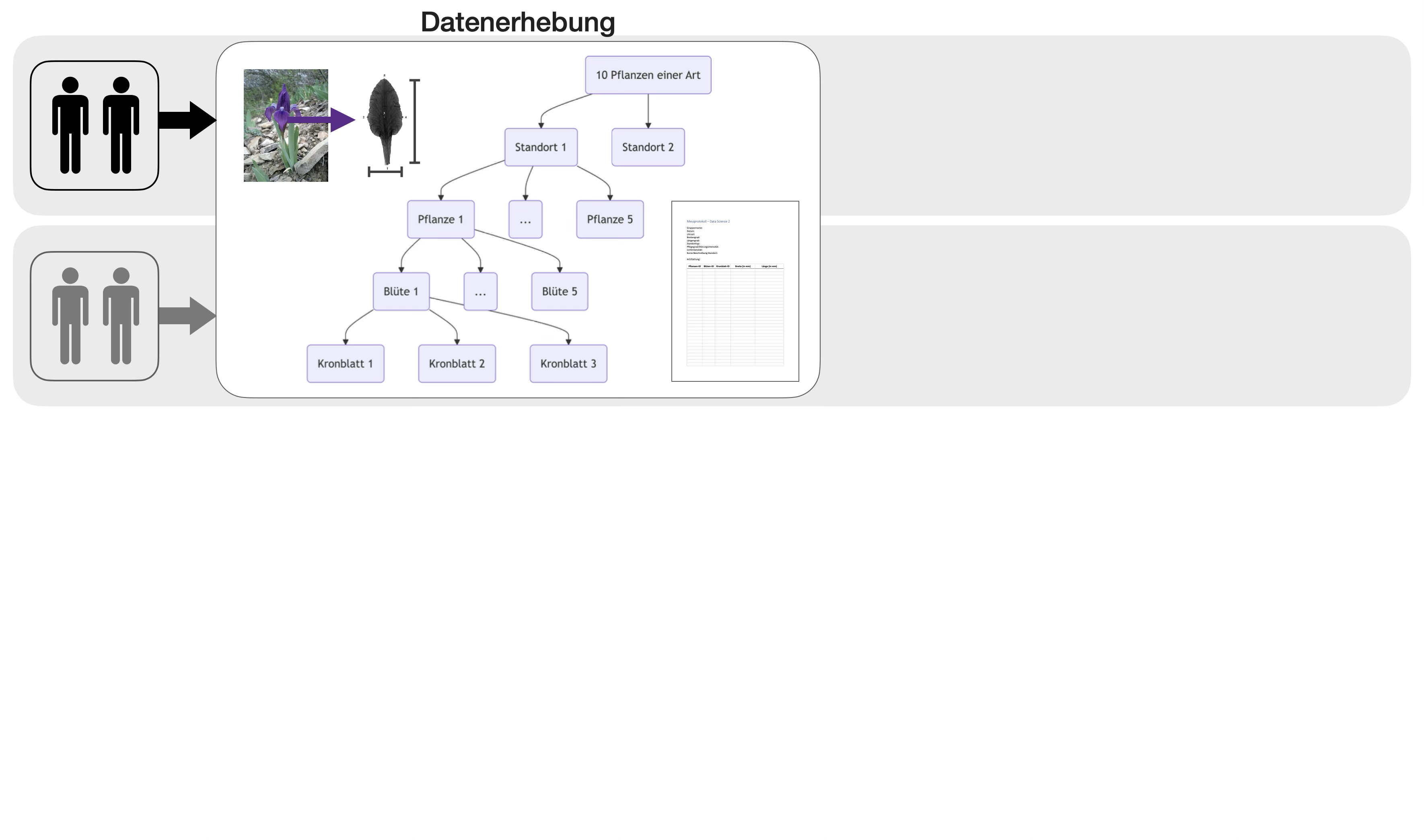

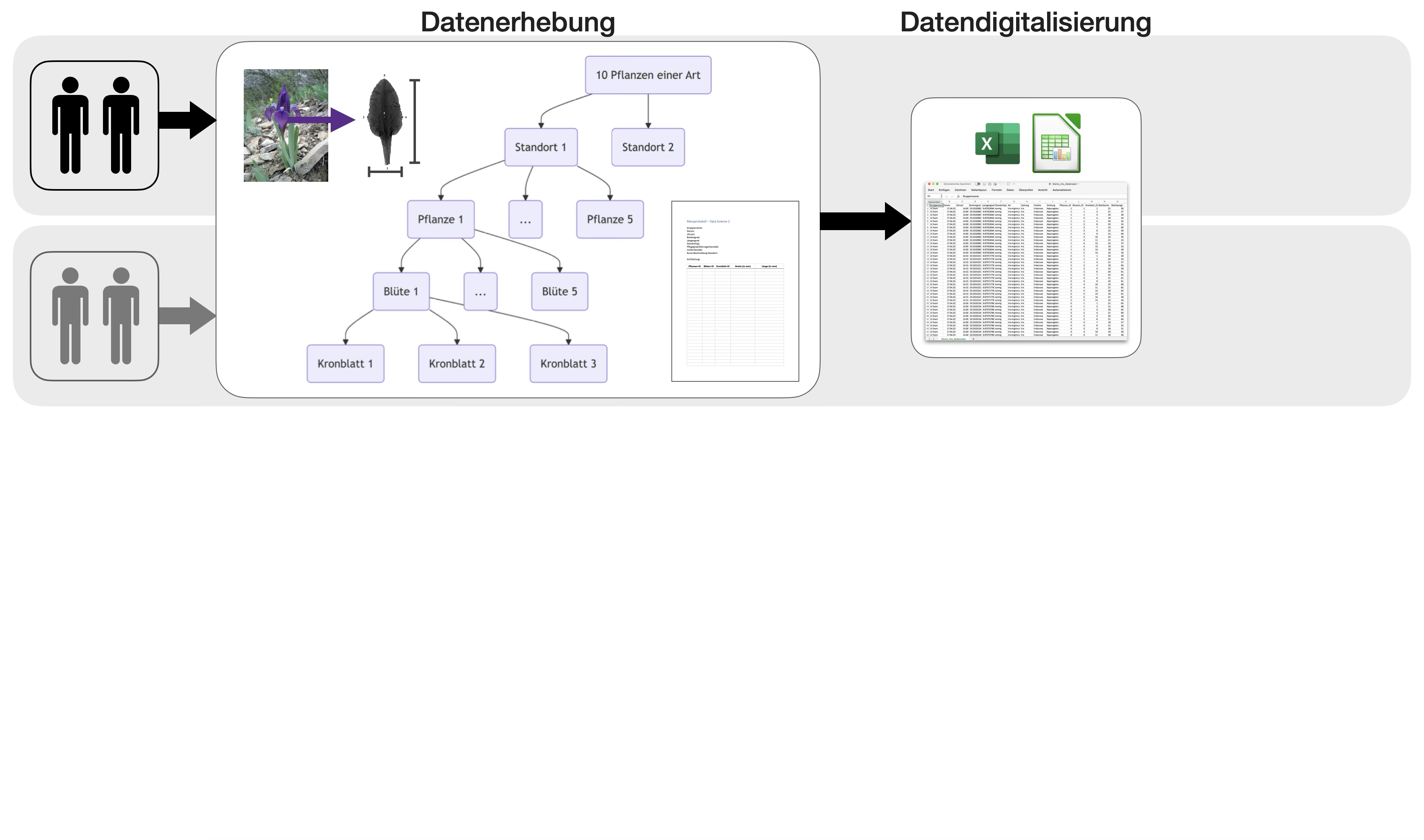

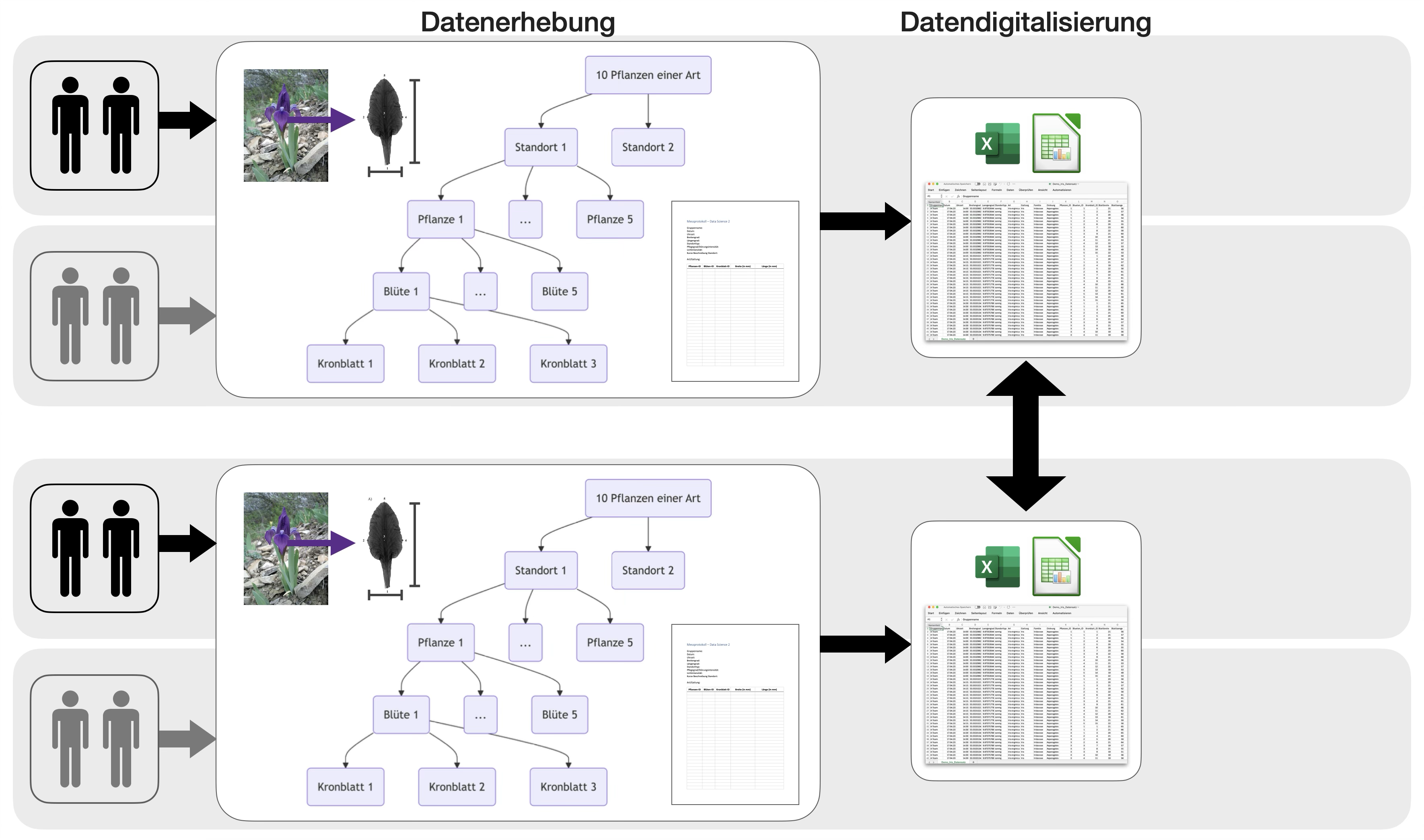

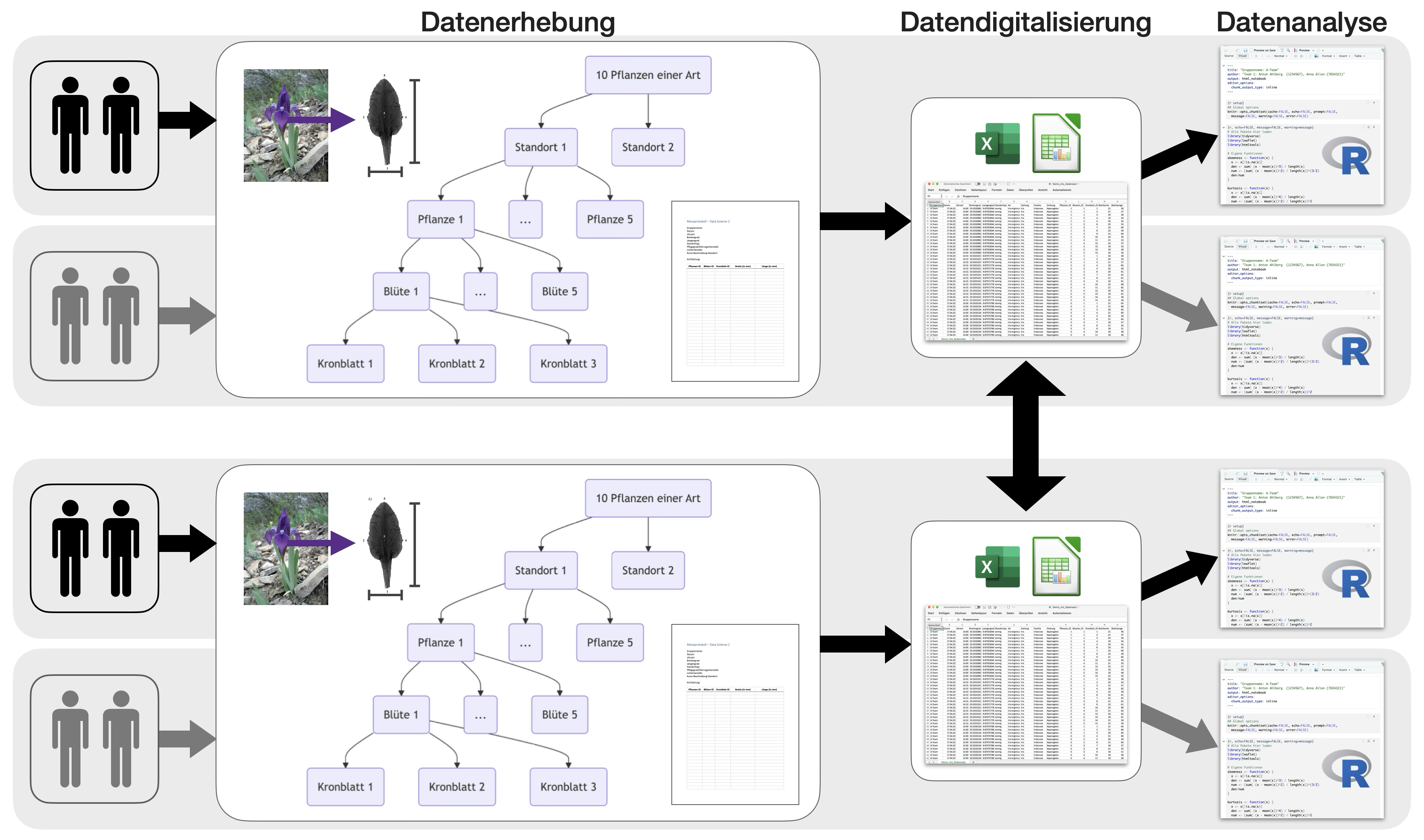

Übungsabschluss | 1

Fallstudie: Blütenallometrie

- begleitend im Semester

- im 2er-Team

Übungsabschluss | 2

Fallstudie: Blütenallometrie

Übungsabschluss | 3

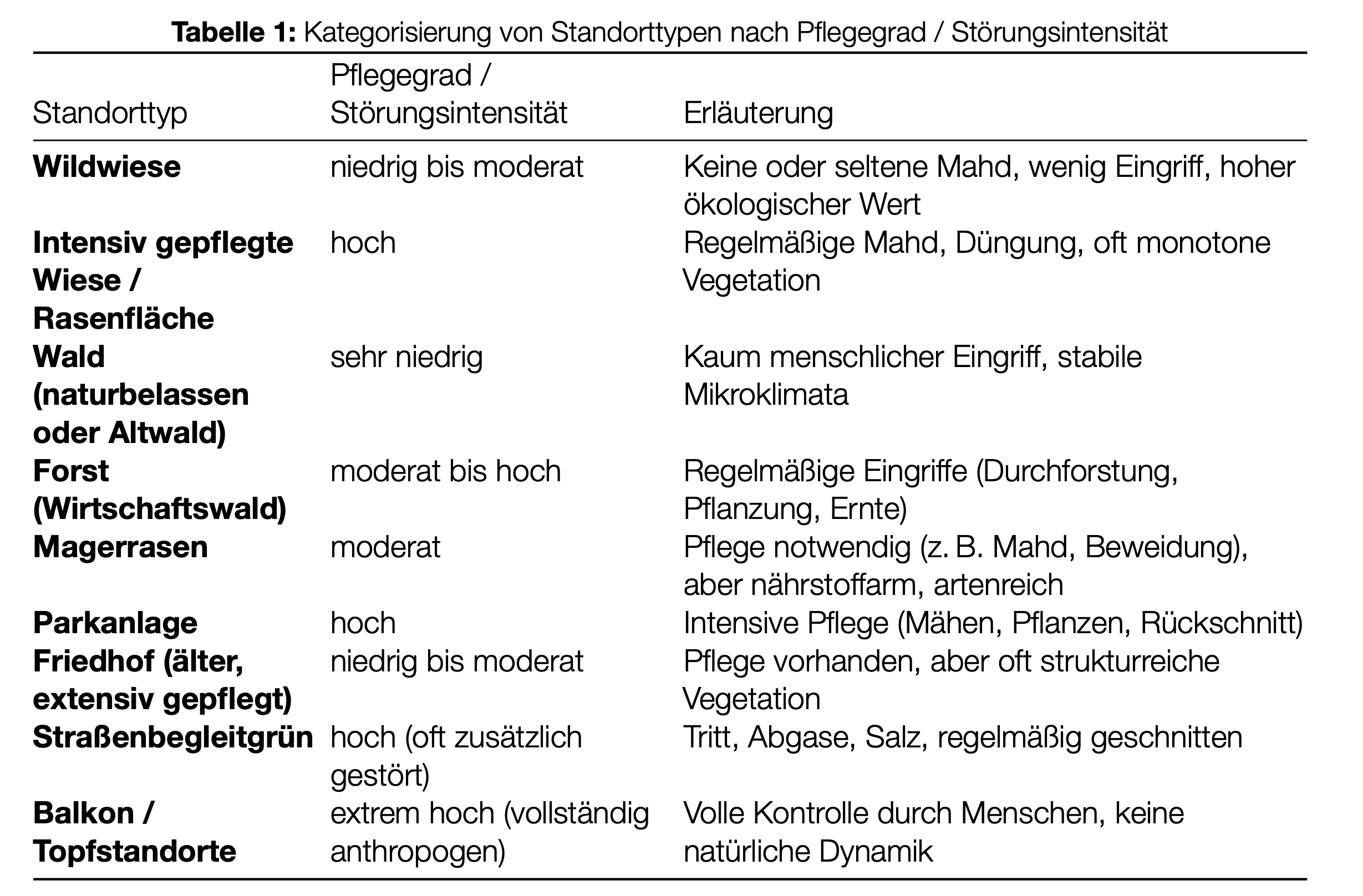

Standorteinteilung

- nach Lichtintensität: sonnig, halbschattig, schattig

- nachPflegegrad/Störungsintensität bzw. Standorttyp:

Das Team

Tutorium zur Vorlesung

- Zur Unterstützung der Vorlesung wird ein begleitendes Tutorium angeboten.

- Der Student Paul Hanke bietet dieses ab Mitte des Semesters (KW 23) online an.

- Das Tutorium findet über Moodle in einem BigBlueButton-Raum statt.

- Weitere Informationen und Termine folgen rechtzeitig auf Moodle.

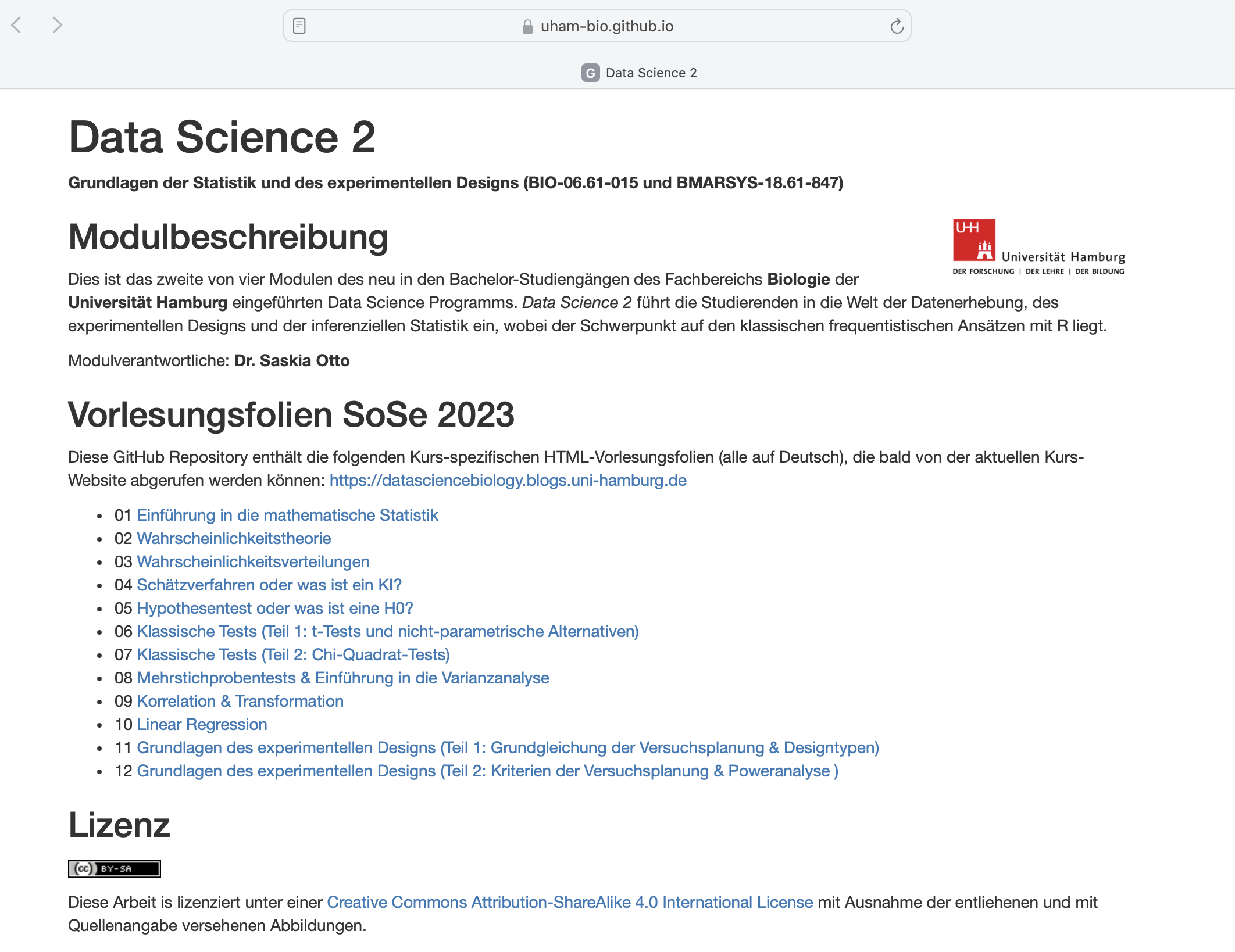

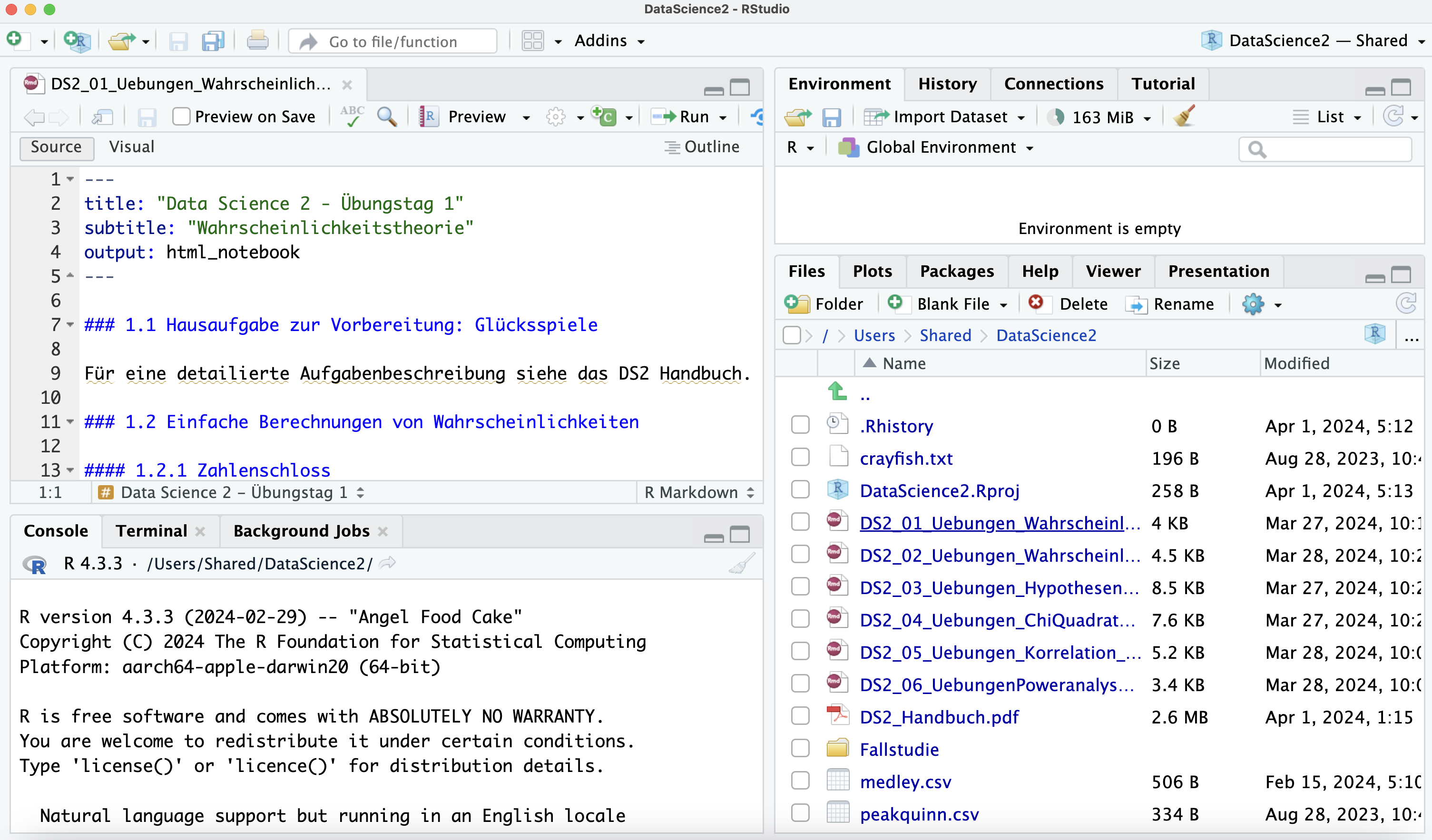

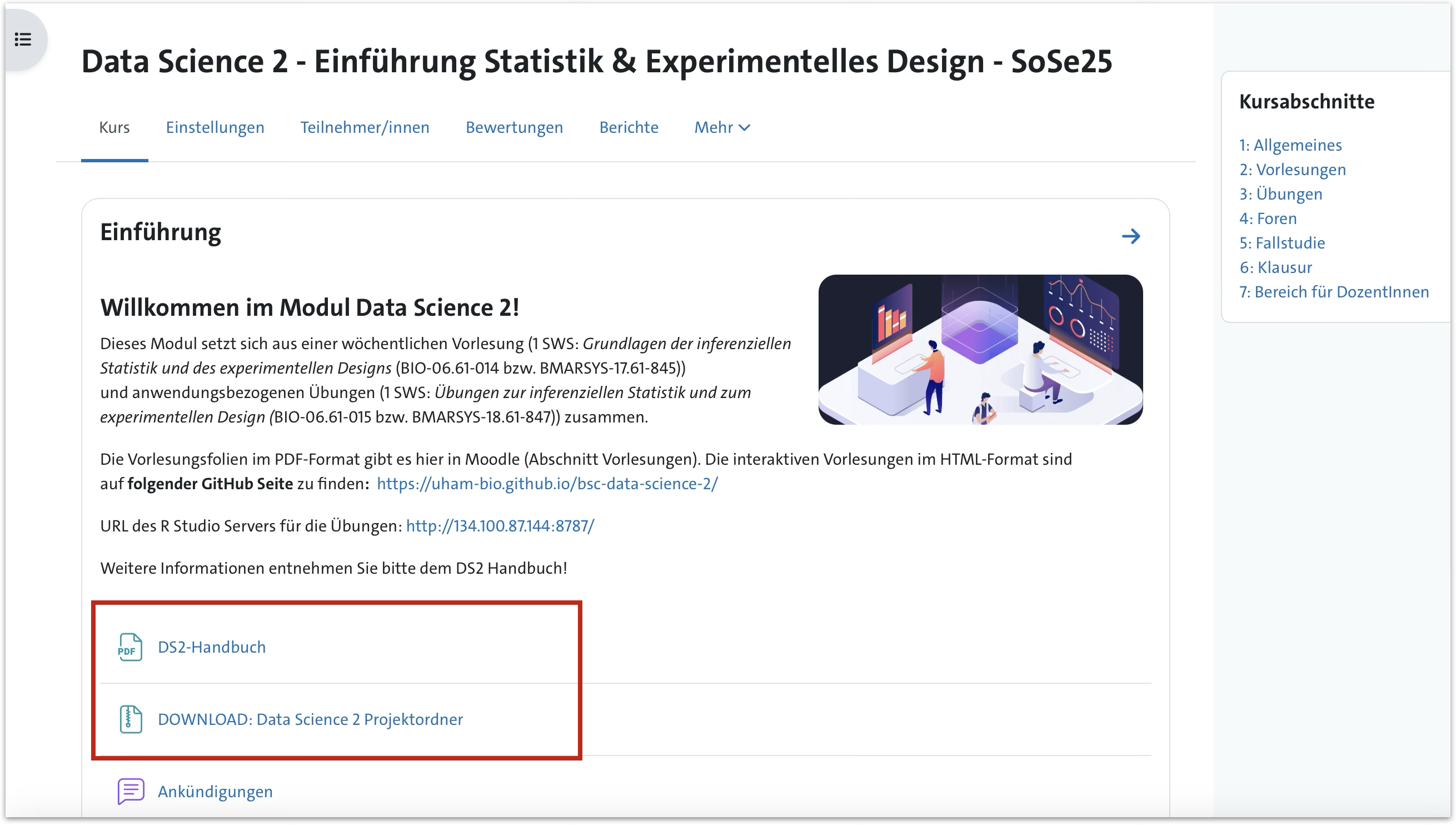

Materialien & Tools

- VL-Folien im HTML-Format

- Handbuch

- Allgeine Modulinformationen

- Formelsammlung

- Übersicht Testauswahl

- Aufgabenstellung Übungen

- Aufgabenstellung Fallstudie

- R Studio-Projektordner → ZIP-Datei zum Download

- R Notebooks

- Daten

- Vorlagen für Fallstudie

- Moodle:

- VL: PDF-Folien, Aufzeichungen

- Quizze begleitend zu den Übungen mit Lösungen

- Fallstudien: Upload Assignments

- Klausur, Klausurvorbereitendes Quiz

- Kommunikationsplattform

- RStudio Server

Literatur

Deutsch

- Bärlocher, F. (1999): Biostatistik - Praktische Einführung in Konzepte und Methoden. Thieme Verlag, 206 S.

- Eickhoff-Schachtebeck, A., Schöbel, A. (2014): Mathematik in der Biologie, Springer Spektrum, 277 S.

Englisch

- Bluman, A.G. (2023): Elementary Statistics: A Step by Step Approach. McGraw-Hill, 11. Edition

- Quinn, G.P., Keough, M.J. (2002): Experimental Design and Data Analysis for Biologists, Cambridge, UK, 553 S.

- R: Lazic, S.E. (2017): Experimental Design for Laboratory Biologists: Maximising Information and Improving Reproducibility. Cambridge University Press, 422 S.

- R: Crawley, M.J. (2013). The R Book, Wiley, 945 S.

Kommunikationswege

- Stellen Sie so weit wie möglich alle Fragen während der Übungsstunden und nach der Vorlesung.

- Außerhalb dessen läuft die Kommunikation über Moodle:

- Spezifische Nachrichten bitte direkt an die Übungsgruppenleiter*innen senden (in Moodle).

- Allgemeine Fragen können im Moodle FAQ Forum gestellt werden, die wir oder auch Sie alle beantworten können.

Sonstiges

- Bitte um Fehlerhinweise und Verbesserungsvorschläge

- Kritischer Umgang mit dem Themengebiet

- Kritik, Fragen, Anmerkungen

- Weitere Fragen?

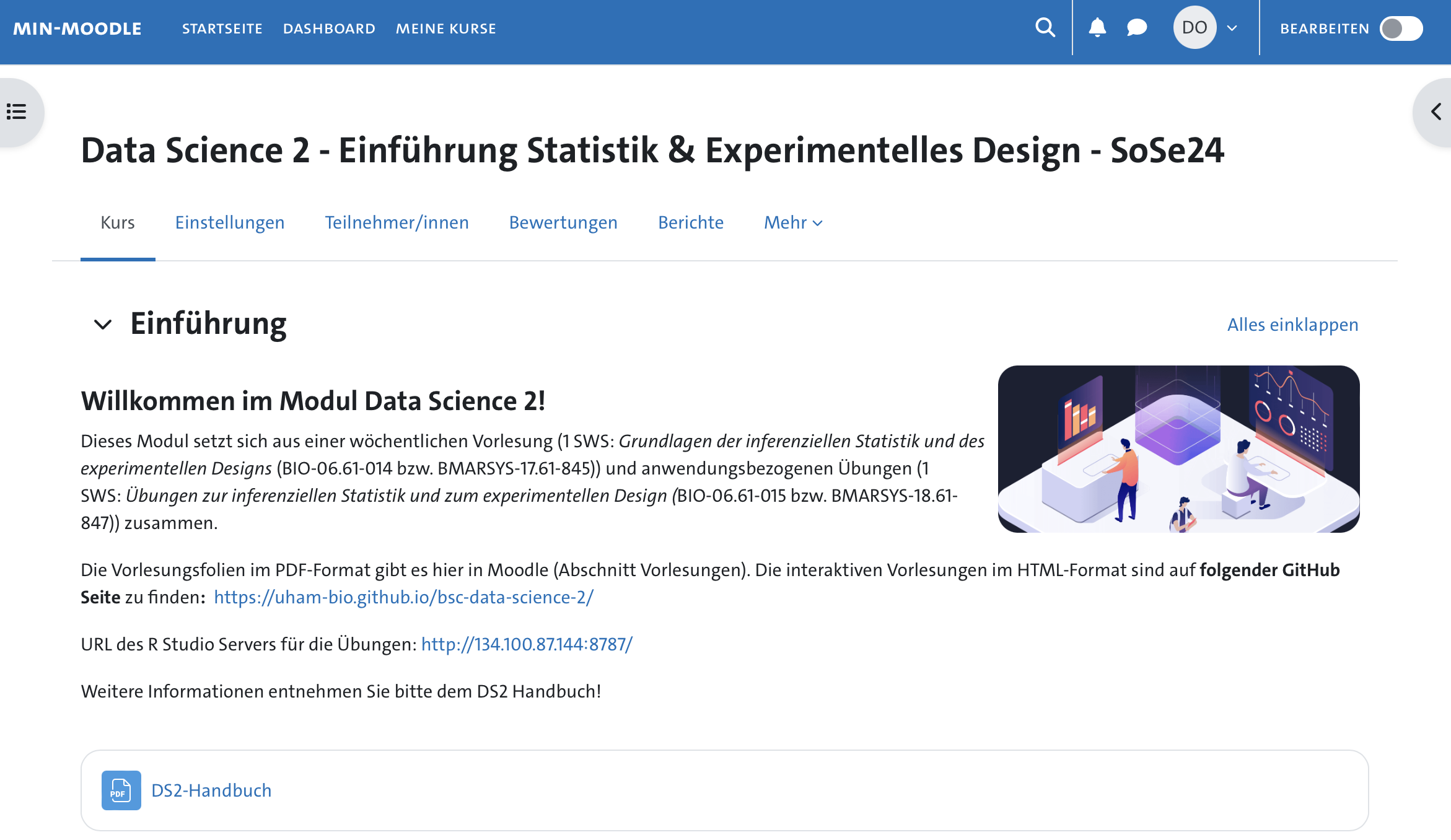

Durchführung wissenschaftlicher Studien

Was hat die Statistik mit dem experimentellen Design zu tun?

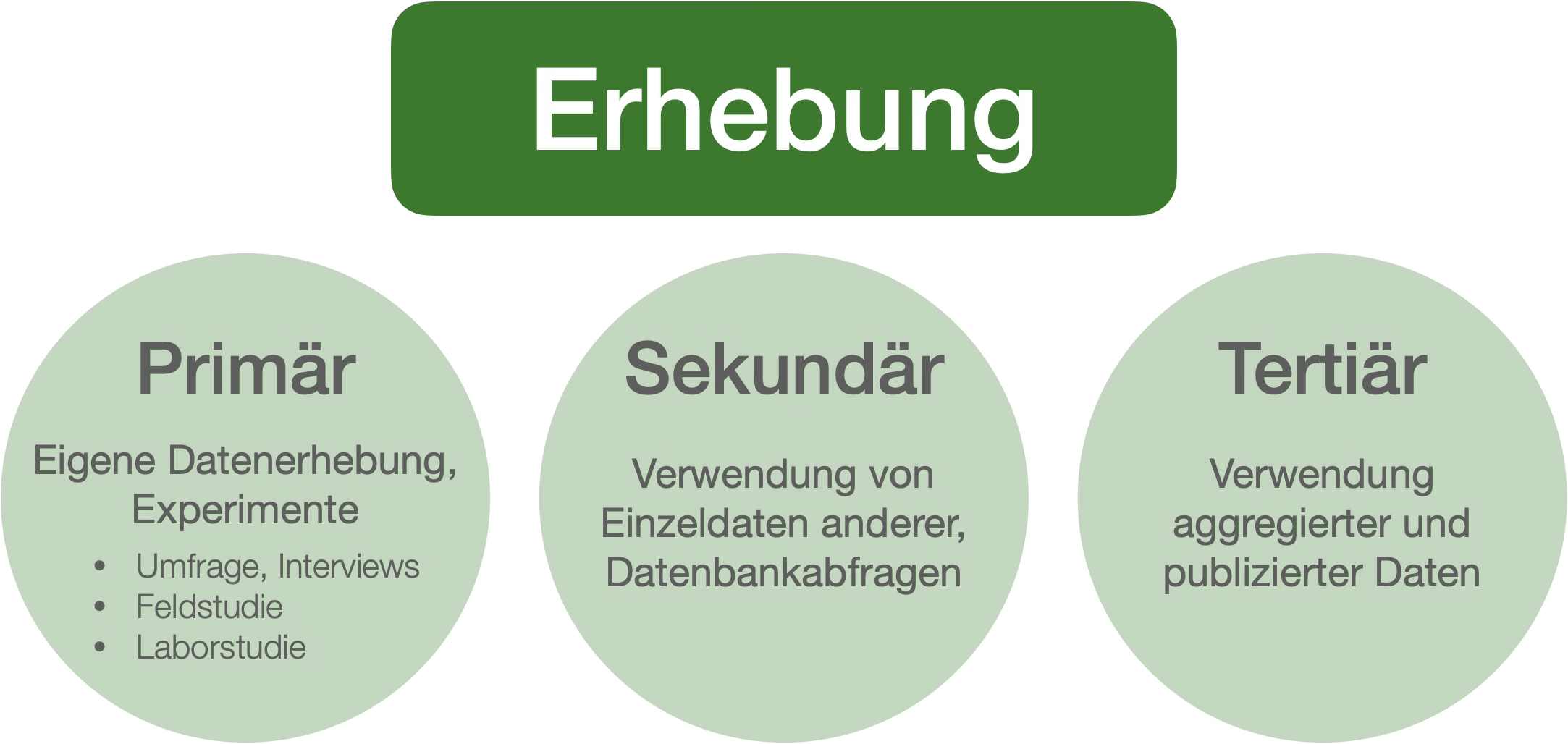

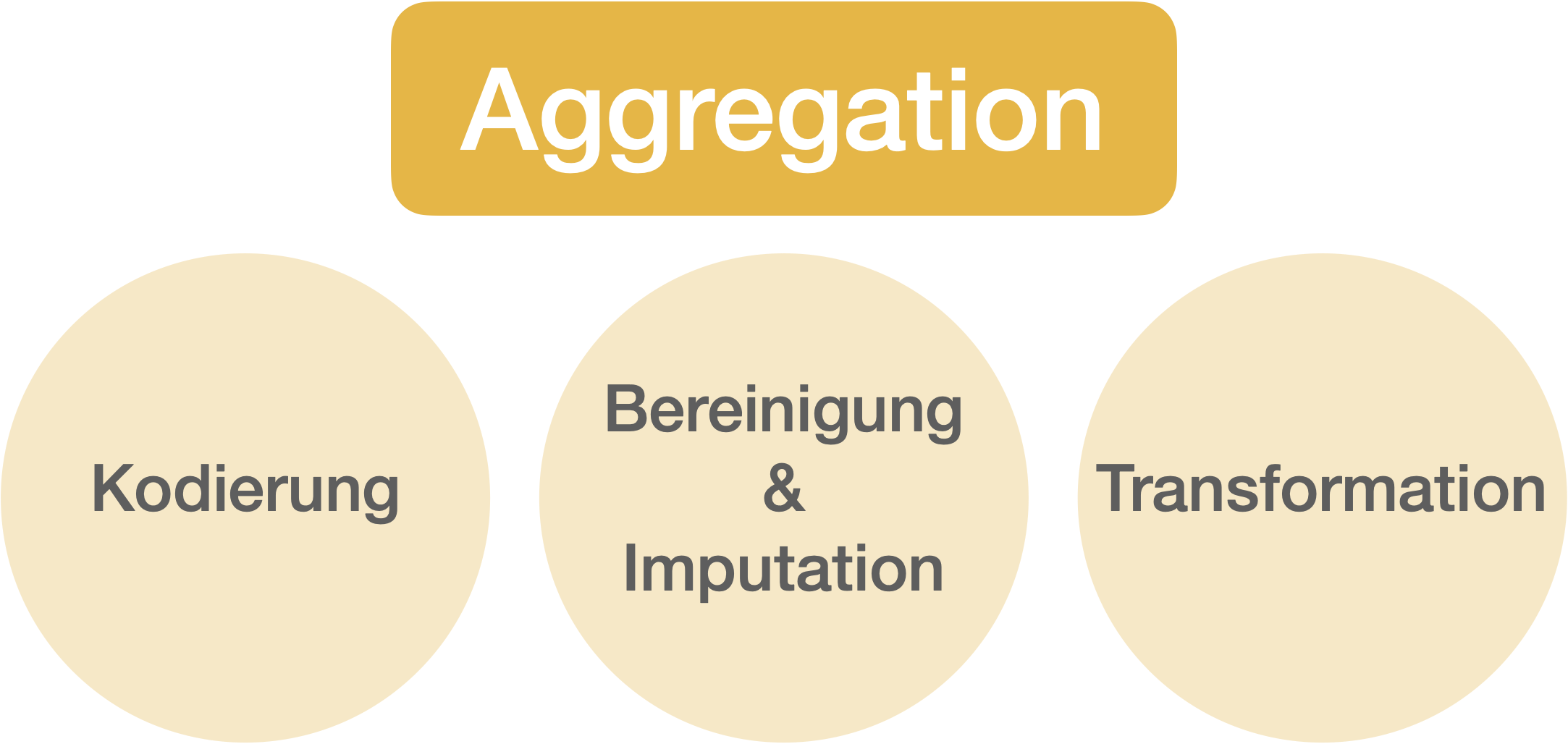

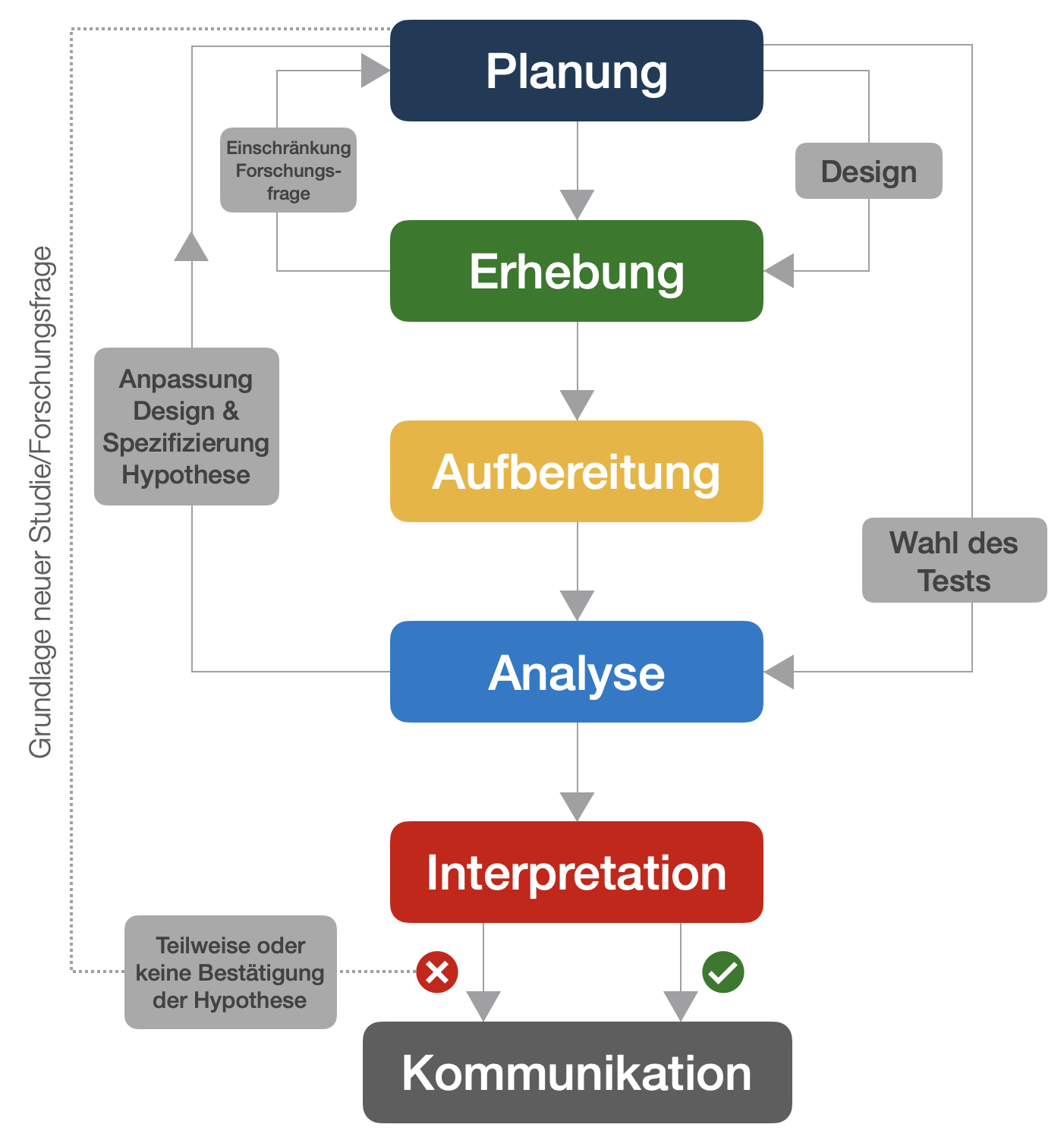

Hauptphasen der Durchführung wissenschaftlicher Studien

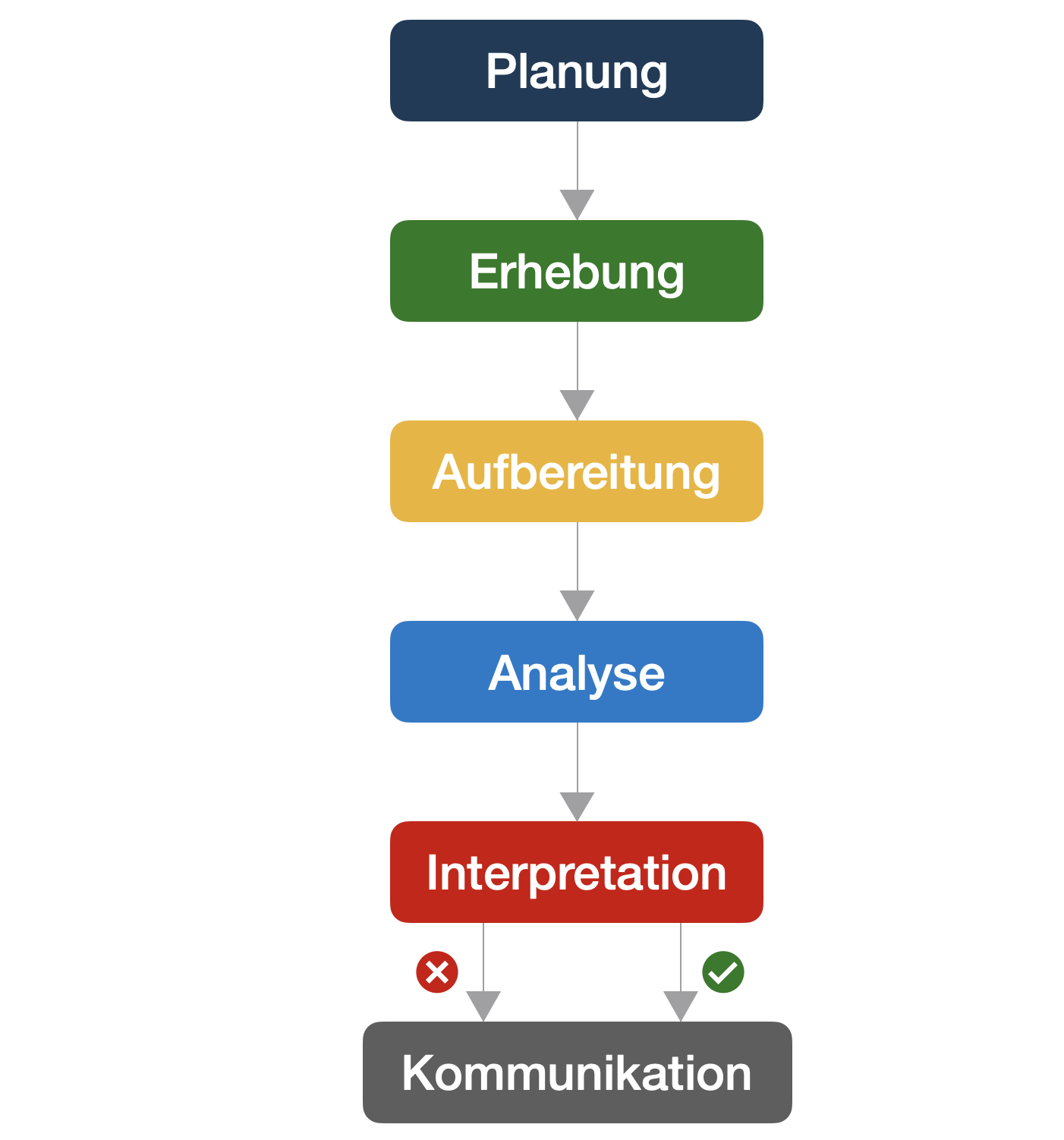

Durchführung wissenschaftlicher Studien | Phase 1

Durchführung wissenschaftlicher Studien | Phase 2

Durchführung wissenschaftlicher Studien | Phase 3

Durchführung wissenschaftlicher Studien | Phase 6

Durchführung wissenschaftlicher Studien

Ständiger Wechsel zwischen den verschiedenen Phasen

Wenn die Analyse nicht in der Planungsphase berücksichtigt wird …

“..Ich entdeckte, dass mehr als ein Jahrzehnt, in dem ich Ökologiestudenten Statistik und Versuchsplanung beigebracht hatte, weitgehend verschwendet war. Die Studenten kamen gegen Ende ihrer Master- oder PhD-Kurse mit Unmengen von Daten zu mir, die für ihre Fragen weitgehend irrelevant waren. Einige dieser Studenten hatten meinen Statistikkurs absolviert, andere hatten Kurse bei professionellen Statistikern in Südbrasilien besucht, und einige hatten Master- oder Bachelor-Abschlüsse von angesehenen amerikanischen, britischen oder französischen Universitäten.” | William E. Magnusson

Im Idealfall gilt,…

- die Studie bzw. das Experiment ist leicht durchführbar.

- bei festem Zeit-, Ressourcen- und Stichprobenaufwand wird ein Maximum an Informationen gewonnen.

- die Ergebnisse sind auf eine Vielzahl von Personen, Bedingungen und Situationen anwendbar.

- die Daten sind einfach zu analysieren und zu interpretieren.

- die Schätzungen sind präzise.

- die Schätzungen sind vor möglichen einmaligen Ereignissen geschützt, die die Ergebnisse beeinträchtigen könnten.

- Effekte können eindeutig und ohne Verzerrung geschätzt werden.

→ Dies kann nur durch eine sorgfältige Planung vorweg erreicht werden, nicht NACHDEM die Daten erhoben wurden.

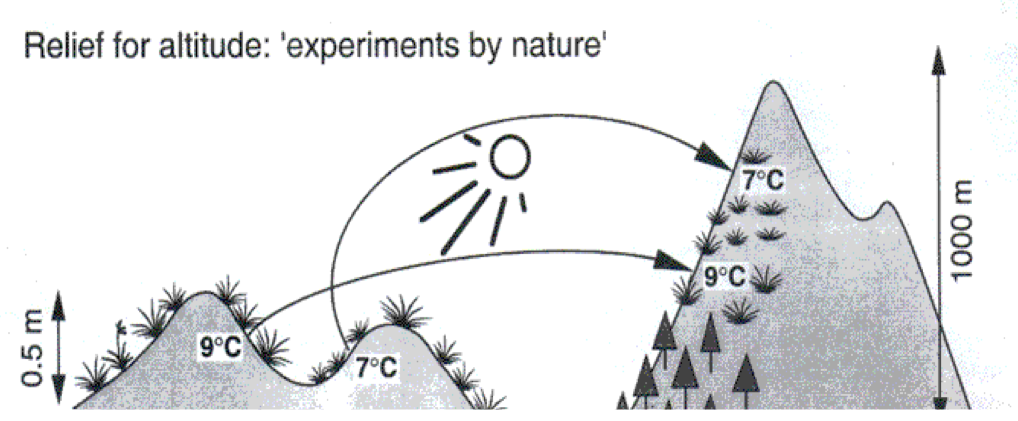

MESSENDE vs. manipulative Experimente | 1

Messende (natürliche, korrelative) Experimente

- Verwendung von bereits bestehenden oder natürlich vorkommenden Behandlungsgruppen.

- Test von Hypothesen über Muster, bestehende Trends oder Beziehungen in der Natur.

- Wenig Kontrolle.

- Dazu gehören auch: Monitorings, Surveys

Messende vs. MANIPULATIVE Experimente | 2

Unter Laborbedingungen

Eines von NOAAs fischereiwissenschaftlichen Laboren zur Untersuchung der Effekte der Ozeanversauerung auf marine Organismen.

Draussen, in Mesokosmen

MEDIMEER (MEDIterranean platform for Marine Ecosystem Experimental Research) Experiment im Frühjahr 2018 in Sète, Frankreich.

Messende vs. MANIPULATIVE Experimente | 3

Manipulative Experimente

- Kontrollierte Manipulation schließt einige alternative Erklärungen (Ursachen) aus.

- Mehrere mögliche Ursachen und ihre Wechselwirkungen können untersucht werden → Manipulation von zwei oder mehr Faktoren

- Probleme mit manipulativen Experimenten:

- In der Regel kleine räumliche und zeitliche Skalen (Relevanz?).

- Kontrollen für Artefakte nicht immer möglich.

- Kann im Labor oder im Feld durchgeführt werden.

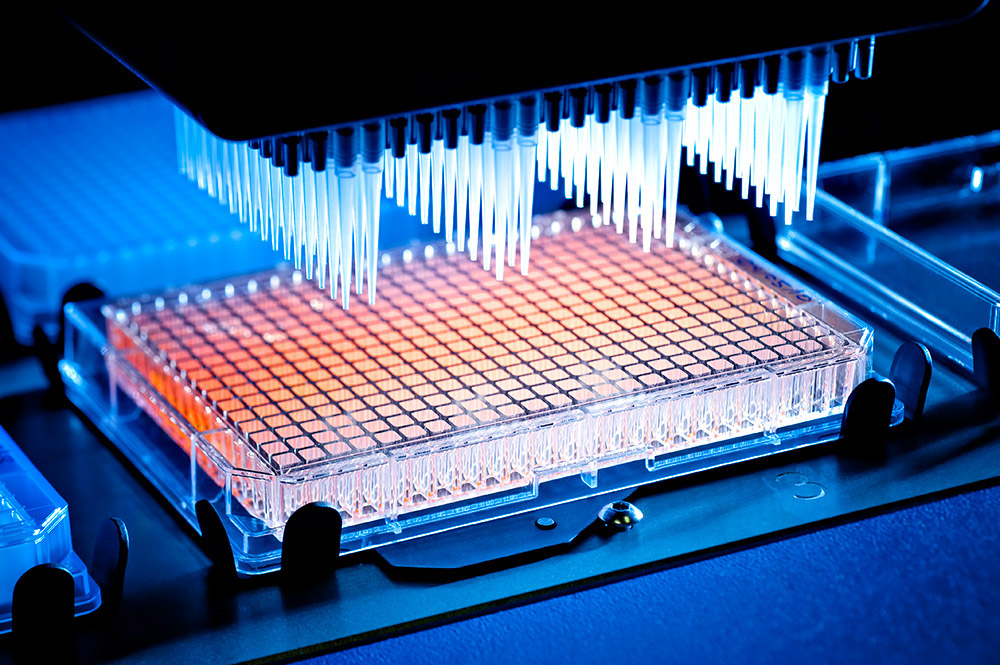

‘LEARNING’ vs. ‘Confirming Experiments’ | 1

Lernende (explorative) Experimente

- Hat das Medikament toxische Nebenwirkungen (in welcher Dosis, über welchen Zeitraum, in welchem Gewebe)?

- Das Ziel ist etwas Neues zu lernen.

- Hypothese ist allgemeiner und ein statistischer Test ist weniger wichtig

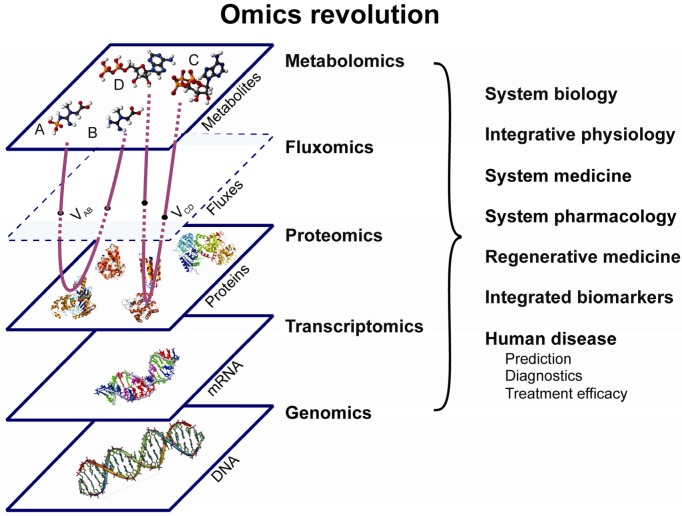

- Typisches Beispiel in der Biologie: ‘High-throughput screening’ in den Omics Wissenschaften.

Emutlu et al. (2012): 18O-assisted dynamic metabolomics

for individualized diagnostics and treatment of human

diseases, Croat Med J 53(6): 529–534

‘Learning’ vs. ‘CONFIRMING Experiments’ | 2

Lernende (explorative) Experimente

- Hat das Medikament toxische Nebenwirkungen (in welcher Dosis, über welchen Zeitraum, in welchem Gewebe)?

- Das Ziel ist etwas neues zu lernen.

- Hypothese ist allgemeiner und ein statistischer Test ist weniger wichtig.

- Typisches Beispiel in der Biologie: ‘High-throughput screening’ in den Omics Wissenschaften.

Bestätigende Experimente

- Erhöht sich die Kreatinkonzentration im Blut, wenn 5 mg/kg des Arzneimittels einmal täglich über 5 Tage verabreicht werden?

- Basieren oft auf lernenden Experimenten.

- Spezifische Hypothesen werden getestet, bei denen häufig die Effektstärke wichtig ist.

Mathematische Statistik

Einführung | Warum brauchen wir Statistik?

- Erleichtert die Interpretation von Daten. ACHTUNG: Statistik stellt keine Fakten dar, sie beschreibt Fakten!!

- Ökologische Systeme sind stochastisch, nicht deterministisch.

- ‘Blaues Lackmuspapier verfärbt sich in Säure IMMER rot’ → statistische Analyse hier unnötig.

- ‘Aspirin hilft nicht immer gegen Kopfschmerzen’ → Statistik hier nötig um die Wahrscheinlichkeit, dass ein Ereignis zufällig erfolgt, einschätzen zu können.

- In jedem Vergleich wird es Unterschiede geben. Die Herausforderung liegt in der Unterscheidung zwischen realen Effekten und zufälliger Variabilität.

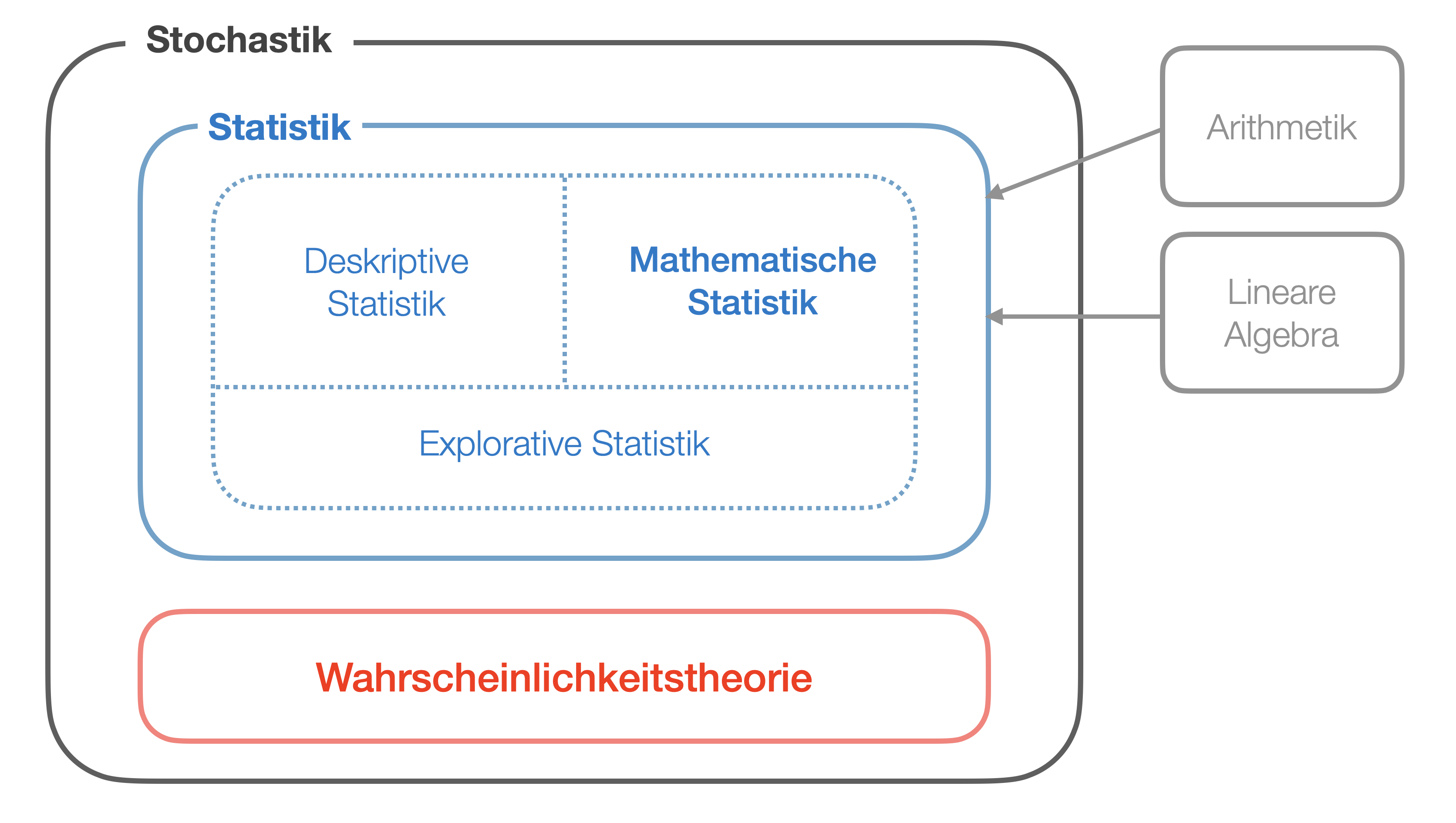

Einführung | Statistik als Teil der Stochastik

Die Statistik ist ein Teilgebiet der reinen Mathematik und betrachtet das Sammeln, die Analyse, die Präsentation und Interpretation von Daten. Sie stellt somit die theoretische Grundlage aller empirischen Forschung dar.

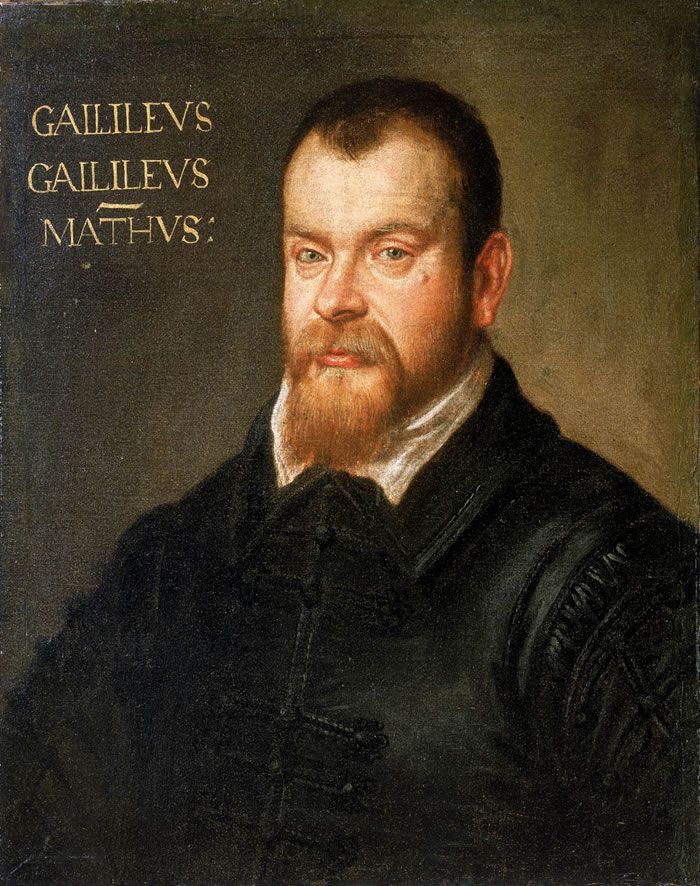

Anstoß zur Wahrscheinlichkeitsrechnung

.. gaben vor allem Glücksspiele Anfang des 17. Jhd.

Bildquelle Roulettespieler: Wikipedia (CC0 Lizenz)

2 Historische Aufgaben aus der Kombinatorik

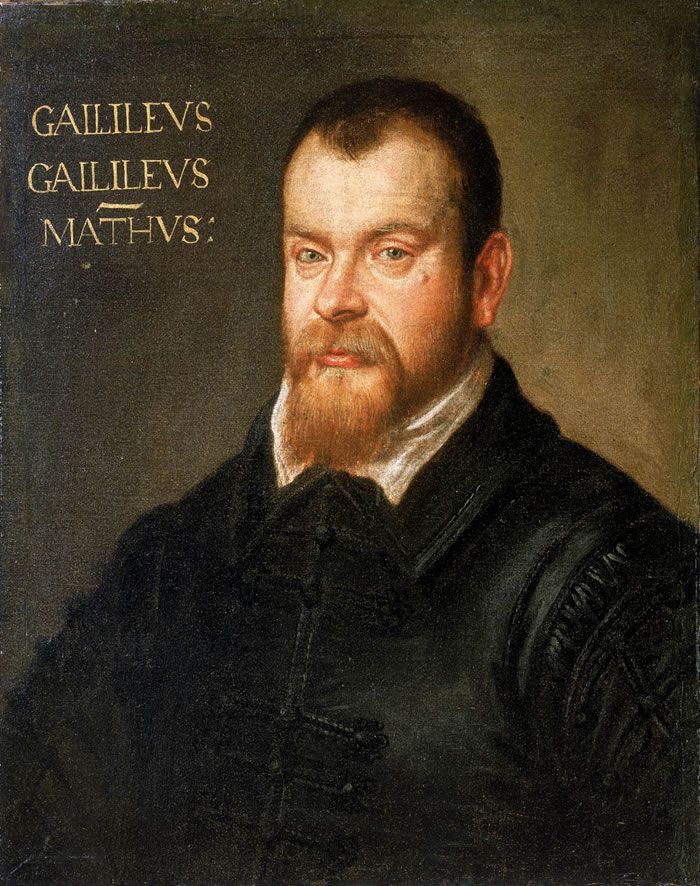

Die Aufgabe von Galileo Galilei

Um 1615 sollen italienische Spieler (in einigen Quellen heißt es auch der Fürst von Toskana) Galilei folgende Frage gestellt haben, welche eine viel diskutierte, Jahrhunderte alte Aufgabe darstellte:

Wie groß sind die Wahrscheinlichkeiten, mit 3 Würfeln eine Summe von 9 oder 10 zu erhalten?

Die damaligen Theoretiker behaupteten, dass beide Summen gleich wahrscheinlich seien. Aus ihrer Erfahrung wussten allerdings die Glücksspieler, dass die 10 häufiger als die 9 autritt.

Das De-Méré-Paradoxon

Als eigentliche Geburtsstunde der mathematischen Wahrscheinlichkeitsrechnung gilt das Jahr 1654. Chevalier de Meré, ein Philosoph und Literat am Hofe Ludwigs des XIV, wandte sich mit folgendem Problem an den bekannten Mathematiker Blaise Pascal:

Was ist wahrscheinlicher, in vier Würfen eines einzelnen Würfels mindestens eine ‘6’ zu würfeln ODER in 24 Würfen eines Würfelpaars mindestens eine ‘Doppelsechs’ zu erzielen?

Auch dieses Problem war damals schon viele Jahrhunderte alt. Allerdings waren die früheren Lösungen falsch.

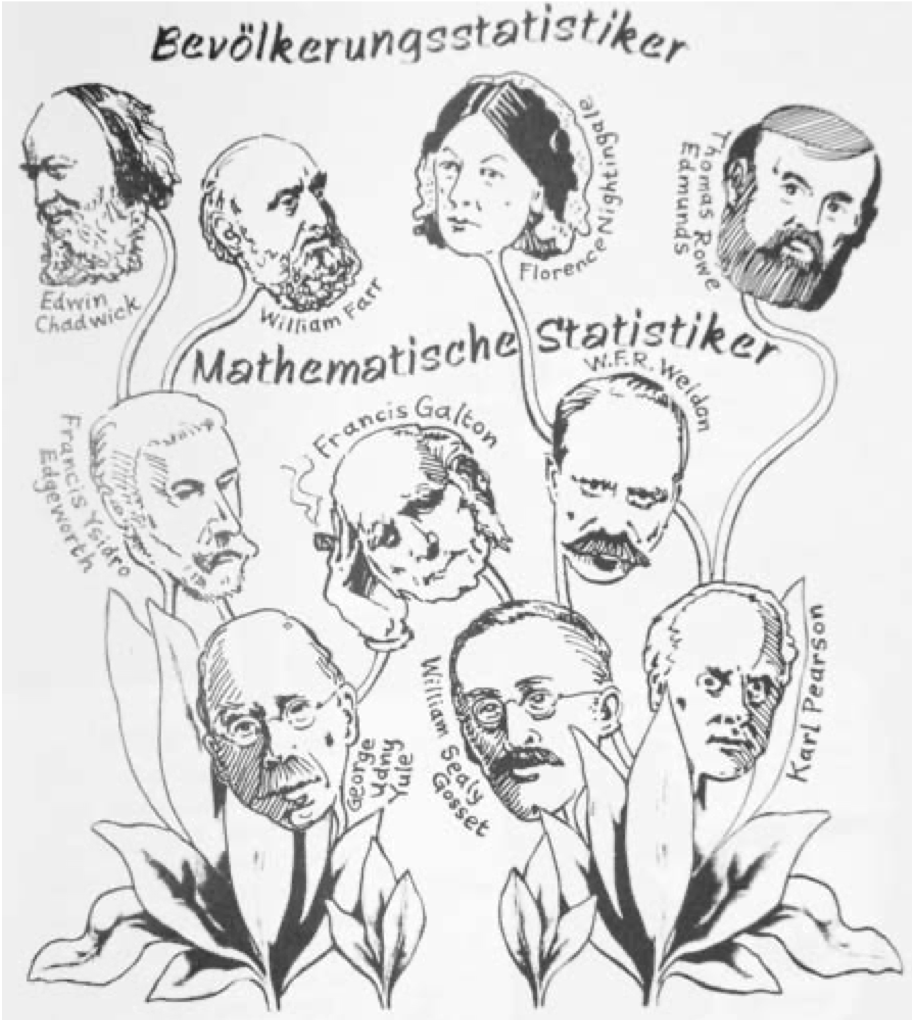

>250 Jahre Statistik | 1

Bevölkerungsstatistik (~19 Jhd.)

- Volkszählungen älteste bekannte Anwendungen der Statistik (erste Volkszählung 1801).

- Bürokratisches Sammeln großer Datenmengen über Bevölkerung → viktorianische Statistiker System entwickelt zur Erfassung von Daten zur Volksgesundheit → führte zu politischen Reformen und Entstehung ‘Public Health Act’;

- Bevölkerungsstatistiker Auffassung, dass statistische Variation Fehlerquelle sei, die man abschaffen müsste; Fokus hier auf Durchschnittswerte (Idee der perfekten Mitte, Lehre des Determinismus).

- Darwins Theorie der biologischen Variation schuf Rahmen für Konzeption neuer statistischer Methoden; Fokus verlagert sich auf die Varianz.

Bildquelle zur Geschichte der Statistik: Magnello & van Loon (2013)

>250 Jahre Statistik | 2

Mathematische Statistik (Ende 19./Anfang 20. Jhd.)

- Mathematische Statistik entstand aus der mathematischen Wahrscheinlichkeitstheorie durch Werke von Bernoulli, Laplace, Gauß und DeMoivre.

- Teilaspekte von Kontinentaleuropa ausgehend, aber meiste von Briten entwickelt. Z.B.

- Francis Galton (Vetter von Charles Darwin): Begründer der Biometrie, entwickelte Grundlagen der Regression und Korrelation

- Karl Pearson: arbeitete \chi^2-Verteilung aus, entwickelte parametrischen Korrelationskoeffizienten

- Ronald A Fisher: entwickelte Grundlagen der Varianzanalyse, Planung von Experimenten, Zufallsanordnungen

Bildquelle zur Geschichte der Statistik: Magnello & van Loon (2013)

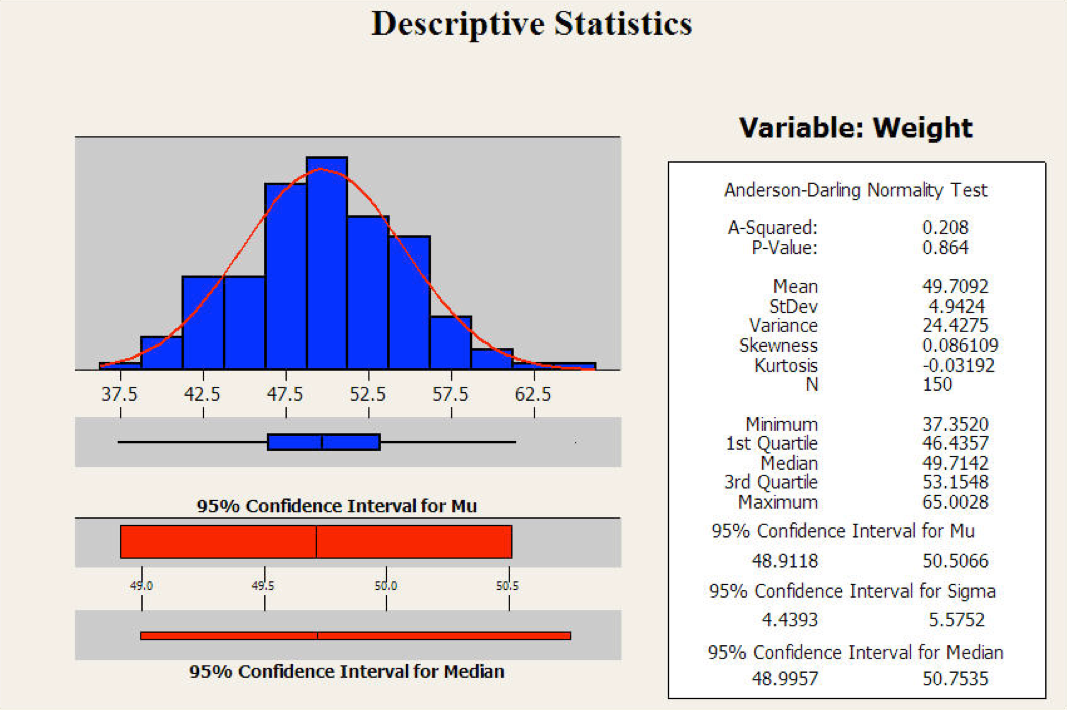

Teilgebiet 1 der Statistik

Deskriptive Statistik

- = beschreibende, empirische Statistik

- Vorliegende Daten werden in geeigneter Weise beschrieben, aufbereitet und zusammengefasst.

- Hauptaufgabe der Statistikämter, Alltagsgebrauch

- 2 Methoden:

- Grafisch (Histogramm, Säulendiagramm) → Aussage über die Verteilung der Werte

- Numerisch (Mittelwert, Varianz) → Aussage über Zentriertheit und Streuung

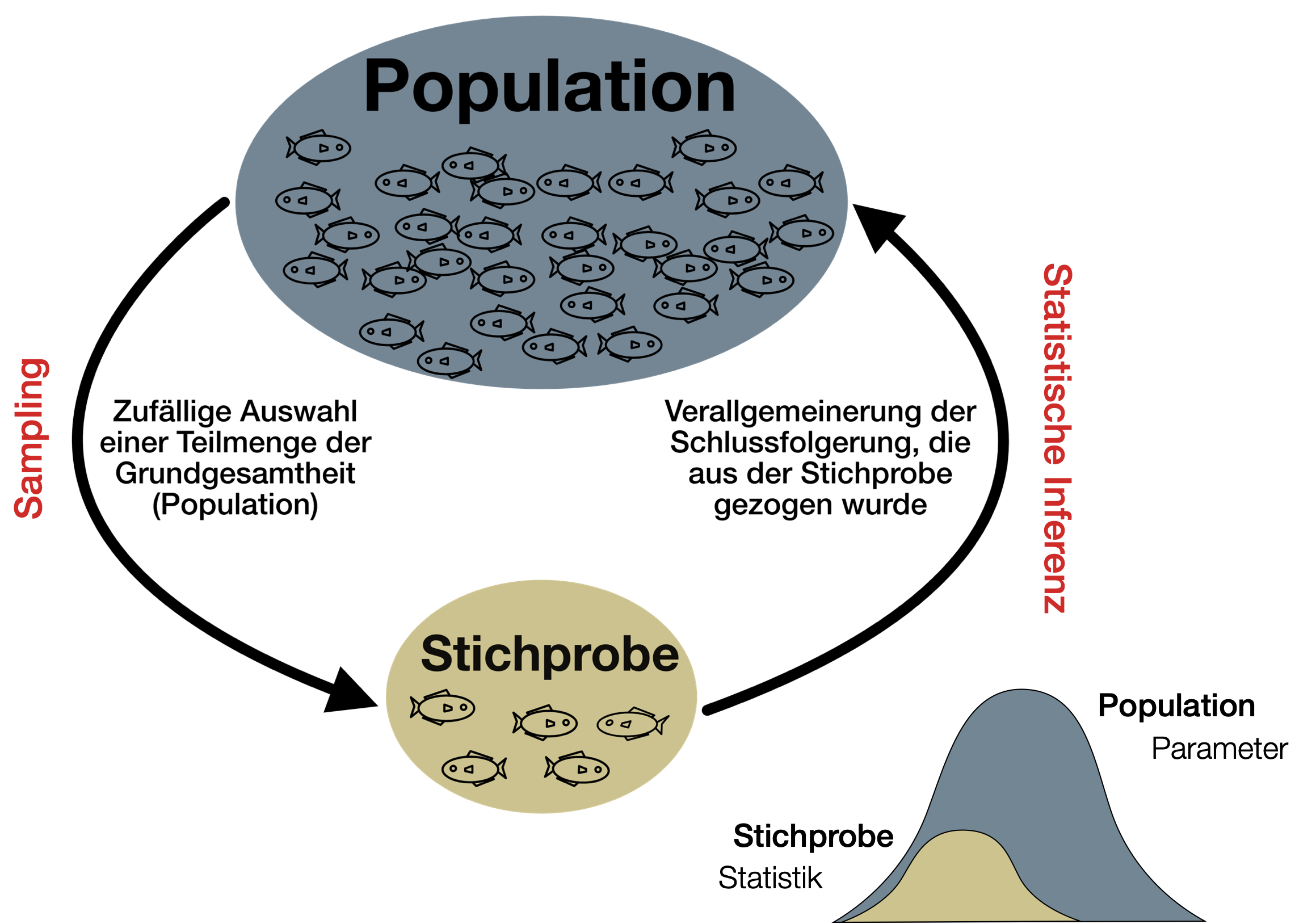

Teilgebiet 2 der Statistik

Mathematische Statistik

- = induktive, schließende Statistik, Inferenzstatistik

- Eigenschaften einer Grundgesamtheit werden aus Daten einer Stichprobe abgeleitet.

- Grundlage der Schätz-und Testverfahren ist die Wahrscheinlichkeitstheorie → Inferenzen sind nie sicher und werden als Wahrscheinlichkeiten ausgedrückt

- Schätzverfahren (estimation): Berechnung von Stichprobenstatistik und Wertebereich indem Populationsparameter mit bestimmter Wahrscheinlichkeit vermutet wird (Konfidenzintervall)

- Testverfahren (hypothesis-testing): setzt eine zu testende Hypothese voraus

- schließt im weiteren auch Prognosen (forecasts/predictions) ein

Teilgebiet 3 der Statistik

Explorative Statistik

- = Hypothesen-generierende, analytische Statistik, explorative Datenanalyse (EDA)

- Große Anwendung im Data Mining.

- Von John W. Tukey in den 1970ern eingeführt.

- Methodisch eine Zwischenform der Teilbereiche 1 und 2.

- Verwendung von Daten um Hypothesen zu entwickeln, die dann mithilfe der mathematischen Statistik getestet werden können.

Statistik in Zeiten der Computer-Ära

Klassische Inferenzstatistik

- Frequentistische Inferenz

- Bayes’sche Inferenz

- Fisher’sche Inferenz und die Maximum-Likelihood-Schätzung

- Parametrische Modelle (Regression, ANOVA, ANCOVA)

Frühe Methoden des Computerzeitalters

- Generalisierte Lineare und Additive Modelle (GLM, GAM)

- Entscheidungsbäume CART (Classification und Regression Trees)

- Überlebensanalyse (survival analysis) und Erwartungs-Maximierungs-Algorithmus

- Jackknife und Bootstrap Methoden

- Markov Chain Monte Carlo

- ARIMA Modelle

Methoden des 21. Jahrhunderts

- Großskalige Hypothesentests und Falscherkennungsraten

- Sparse Modeling und Lasso Regression

- Random Forests und Boosting

- Neuronale Netzwerke und Deep Learning

- Support-Vector Machines und Kernel Methoden

- Empirische Bayes Schätzstrategien

Interview mit Travor Hastie und Bradley Effron

Youtube Link zum Interview: https://www.youtube.com/watch?v=quoU5fjKBqo (Min. 3:06 und 7:00)

Grundsätzlich gilt in der Statistik

Take-home message

- Statistische Analysen können NICHT falsch gesammelte, unvollständige oder unzuverlässige Daten kompensieren!

- Statistische Auswertungen sollten nicht einfach kochbuchmäßig ausgeführt werden (zunehmende Gefahr mit aktuellen Computerprogrammen und zugänglichen Programmierskripten)

- Hintergründe und Voraussetzungen der Methoden sollten bekannt sein → dabei sind die mathematischen Formeln weniger wichtig als der zugrundeliegende philosophische Ansatz.

Übungsaufgaben

![]()

Vorbereitungen (VOR 1. Übung)

Downloads von Handbuch und Projektordner

Fallstudie

- Lesen Sie die Aufgabenbeschreibung durch.

- Bilden Sie 2er-Teams und überlegen Sie sich,

- mit welchen anderen 2er-Teams Sie zusammenarbeiten wollen.

- welche Art und welche Standorte Sie beproben wollen (welche Fragestellung).

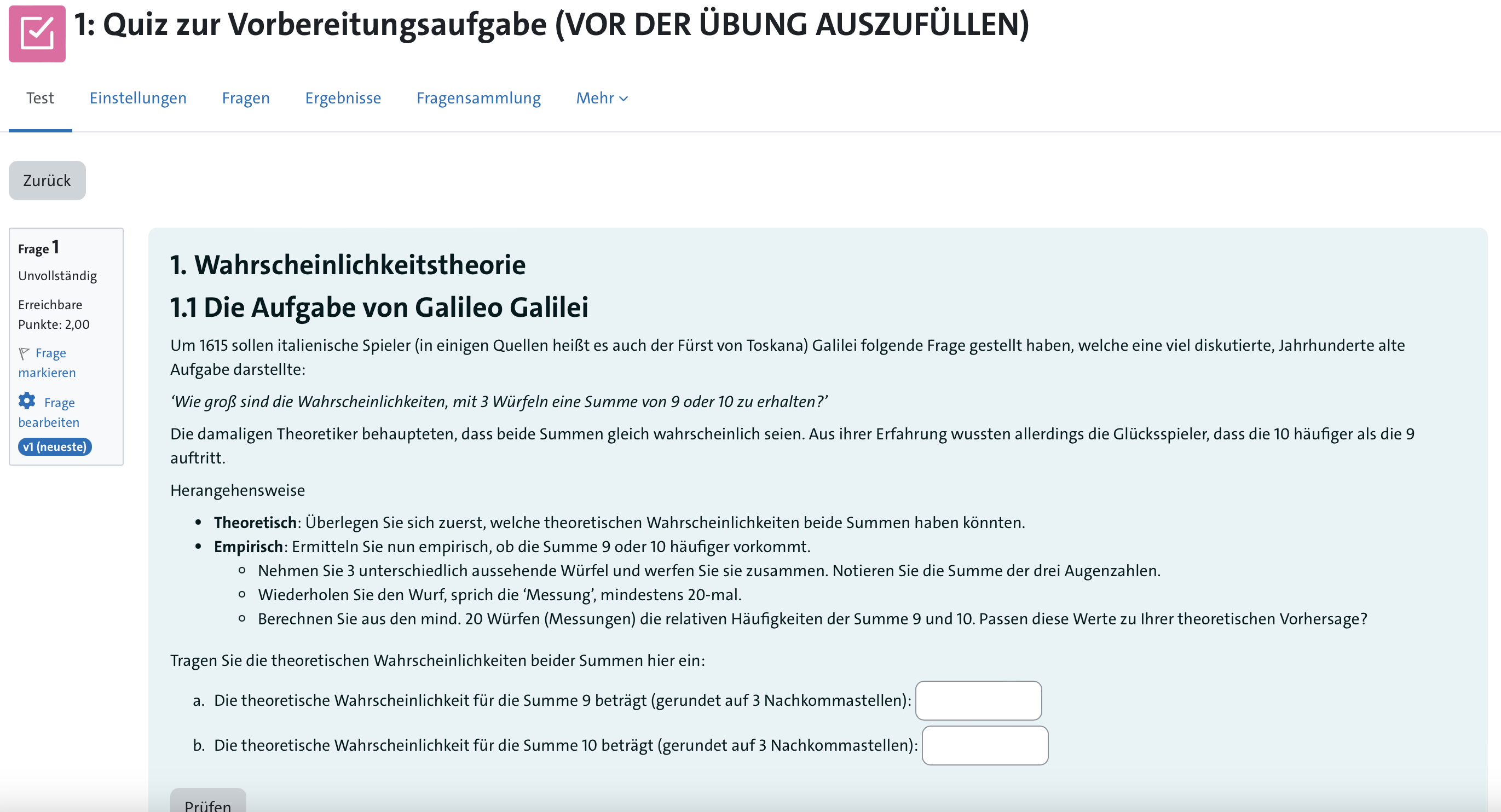

Aufgabe 1: Die Aufgabe von Galileo Galilei

Wie groß sind die Wahrscheinlichkeiten, mit 3 Würfeln eine Summe von 9 oder 10 zu erhalten?

Herangehensweise

- Theoretisch: Überlege Dir zuerst welche theoretischen Wahrscheinlichkeiten beide Summen haben könnten.

- Empirisch: Nun ermittle empirisch, ob die Summe 9 oder 10 häufiger vorkommt.

- Nimm 3 unterschiedlich aussehende Würfel und werfe sie zusammen. Notiere Dir die Summe der drei Augenzahlen.

- Wiederhole den Wurf, sprich die ‘Messung’, mindestens 20-mal.

- Berechne aus den mind. 20 Würfen (Messungen) die relativen Häufigkeiten der Summe 9 und 10. Passen diese Werte zu Deiner theoretischen Vorhersage?

Aufgabe 2: Die Aufgaben des Chevalier de Meré

Was ist wahrscheinlicher, in vier Würfen eines einzelnen Würfels mindestens eine ‘6’ zu würfeln (Variante A) ODER in 24 Würfen eines Würfelpaars mindestens eine ‘Doppelsechs’ zu erzielen (Variante B)?

Herangehensweise

- Theoretisch: Überlege Dir zuerst welche theoretischen Wahrscheinlichkeiten beide Varianten haben könnten.

- Empirisch: Nun ermittle empirisch, ob die Variante A oder B häufiger vorkommt.

- Führe Variante A und B getrennt durch und notiere Dir die Gesamtaugenzahl bei jedem Wurf (= Messung).

- Wiederhole jede Messung mindestens 20-mal.

- Berechne aus den mind. 20 Messungen die relativen Häufigkeiten der ‘6’ (Variante A) und der ‘Doppelsechs’ (Variante B). Passen diese Werte zu Deiner theoretischen Vorhersage?

Moodle-Quiz

Fragen?

Abschlussquiz

![]()

Bei weiteren Fragen: saskia.otto(at)uni-hamburg.de

Diese Arbeit is lizenziert unter einer Creative Commons Attribution-ShareAlike 4.0 International License mit Ausnahme der entliehenen und mit Quellenangabe versehenen Abbildungen.

Kurswebseite: Data Science 2